使用 Ollama 轻松部署 DeepSeek-R1 系列模型:Windows, Linux, macOS, Android 全平台指南

DeepSeek-R1 系列模型以其卓越的性能和开源特性,吸引了众多开发者的关注。Ollama 作为一个轻量级的模型运行平台,使得部署和使用这些模型变得异常简单。本文将详细介绍如何在 Windows, Linux, macOS 以及 Android 平台上使用 Ollama 部署 DeepSeek-R1 系列模型,包括 DeepSeek-R1-Distill-Qwen-1.5B, DeepSeek-R1-Distill-Qwen-7B, DeepSeek-R1-Distill-Llama-8B, DeepSeek-R1-Distill-Qwen-14B, DeepSeek-R1-Distill-Qwen-32B 和 DeepSeek-R1-Distill-Llama-70B。 针对低配置设备,我们也会重点介绍部署 DeepSeek-R1-Distill-Qwen-1.5B 模型。

为什么选择 Ollama?

- 简单易用: Ollama 简化了模型下载、安装和运行的复杂过程。

- 跨平台支持: Ollama 支持 Windows, Linux, macOS 和 Android 平台。

- 轻量级: Ollama 资源占用低,即使在配置较低的设备上也能流畅运行。

- 社区驱动: Ollama 拥有活跃的社区,提供丰富的模型和技术支持。

准备工作

在开始之前,请确保满足以下条件:

- 硬件要求: 根据所选模型的规模,需要足够的内存和磁盘空间。DeepSeek-R1-Distill-Qwen-1.5B 模型对硬件要求较低,适合低配置设备。

- Ollama 安装包: 从 Ollama 官网下载对应平台的安装包: https://ollama.com/

第一部分:Ollama 安装

1. Windows 平台

- 下载 Windows 版本的 Ollama 安装包 (

.exe 文件)。

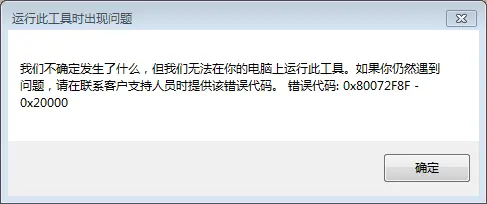

- 双击安装包,按照提示完成安装。

- 安装完成后,在命令提示符或 PowerShell 中输入

ollama --version 验证安装是否成功。